Azure ETL(Azure Data Factory)の機能と料金、活用メリットを解説

デジタルトランスフォーメーション(DX)が進む現代において、企業が保有する多種多様なデータを迅速かつ正確に分析基盤に取り込む ETL(Extract, Transform, Load)プロセス は、競争優位性を確立するための鍵となります。

特に Microsoft Azure の強力なクラウドインフラとETLツールを連携させることで、従来のオンプレミス環境では実現が難しかった、スケーラブルで効率的なデータ統合が可能になります。

本記事では、Azureが提供するクラウドネイティブなETL/データ統合サービスである Azure Data Factory (ADF) に焦点を当て、その基本的な仕組みから、具体的な機能、コストメリット、そして導入に適した企業像までを徹底的に解説します。

目次

- Azure ETL(Azure Data Factory)とは?

- ETLツールとは?

- Azure ETL(Azure Data Factory)の主な機能

- Azure ETL(Azure Data Factory)の料金形態

- Azure導入に向いている企業

- まとめ

Azure ETL(Azure Data Factory)とは?

Azure Data Factory (ADF) は、Microsoftが提供するクラウドETL/データ統合サービス です。

ADFの主要な役割は、オンプレミス、他社クラウド、およびAzureサービス上に分散したデータを抽出し、ビジネス分析に適した形式に変換・統合するプロセス(ETL/ELT)を、サーバーレス環境で自動的に実行することにあります。

ノーコード/ローコードによるデータ統合・加工

ADFは、複雑なデータ統合ワークフローの開発を大幅に簡素化します。

特に「マッピングデータフロー (Mapping Data Flow)」機能により、ユーザーはコーディングを必要とせず、直感的なグラフィカルインターフェース(GUI)上で大規模なデータ変換ロジックを設計・実行できます。これにより、開発期間の短縮と、データエンジニアリング以外の部門によるデータ統合への関与を促進し、開発効率とビジネスアジリティの向上 に貢献します。

豊富な組み込みコネクタによる広範なデータ連携

ADFは、データソースへの高い接続互換性を誇ります。

90種類以上 の組み込みコネクタが提供されており、主要なデータベース、SaaSアプリケーション、クラウドストレージ、ビッグデータプラットフォームなど、多岐にわたるシステムとの連携をセキュアかつ容易に実現します。この広範な接続性により、企業はハイブリッドクラウド環境における複雑なデータ統合課題に対応し、全社的なデータ活用基盤 の構築を推進できます。

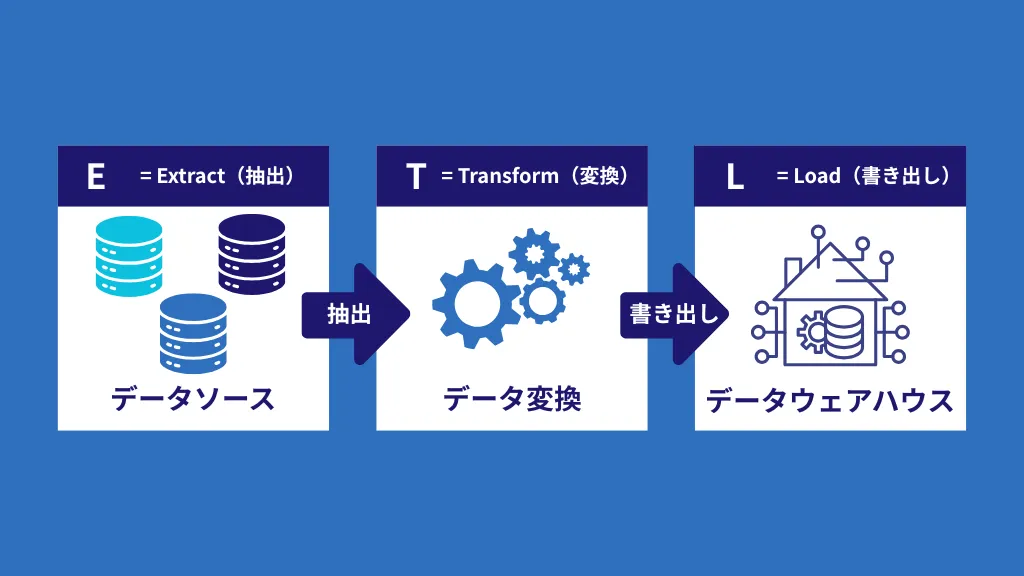

ETLツールとは?

ETLとは、「Extract(抽出)」、「Transform(変換・加工)」、「Load(格納)」の頭文字を取った略語です。これは、企業内にバラバラに存在するデータを一つに集め、分析しやすい状態に整えるための一連のプロセス、またはその仕組みを提供するツールを指します。

ETLツールは、以下の3つの機能で、データの統合管理を実現します。

Extract(抽出)

必要なデータを社内の様々なシステム(SaaS、データベース、ログファイルなど)から取得します。

各部門やシステムが独自のデータを抱え込み、組織全体での横断的なデータ活用が極めて困難になるのです。このサイロ化されたデータを短期間ですべて統合することは、ETLプロセスの構築に多大なリソースを割くこととなります。

Transform(変換・加工)

取得したデータを、分析に適した形式や、格納先のルールに合わせて整形、クレンジング(重複・欠損値の除去)します。

Load(格納)

変換・加工を終えたデータを、BigQueryのようなデータウェアハウスや他のシステムに書き込み(格納)ます。

Azure ETL(Azure Data Factory)の主な機能

Azure Data Factory(ADF)は、単なるデータ転送ツールではなく、データ統合プロセス全体を管理・実行するための包括的な機能群を提供します。

その主な機能は以下の通りであり、それぞれがデータ活用の効率化を強力にサポートします。

- データ取り込み

- ノーコードでデータ変換

- モニタリング機能

データ取り込み

ADFは、企業のデータ統合基盤において最も重要な「データの抽出(Extract)」と「格納(Load)」を、高速かつセキュアに実行する機能を提供します。

ADFの最大の強みは、90種類以上の組み込みコネクタを提供している接続性の高さにあります。これにより、以下のような多岐にわたるデータソースにシームレスに接続し、データを統合することが可能です。

- クラウドデータウェアハウス

BigQuery、Amazon Redshiftなど - オンプレミスデータストレージ

Oracle ExadataやTeradataなどの高性能データベース - SaaSアプリケーション

Salesforce、kintoneなどのビジネスアプリケーション

データ変換

データの変換(Transform)は、ETLプロセスにおいて最も重要なステップの一つです。Azure Data Factoryは、この複雑な変換作業を効率化するための強力な機能を提供します。

ストレージに保存されているデータを自動で変換

ADFのパイプラインは、Azure Blob StorageやAzure Data Lake Storageといったストレージサービスに保存されているデータを自動で読み込み、ユーザーが定義した変換ロジックに基づいて加工することができます。この機能により、データウェアハウスに格納する前に、データのクレンジング、集計、結合といった前処理を柔軟に実行可能です。

専門知識不要のビジュアルなデータフロー設計

ADFの核となる機能の一つが「マッピングデータフロー (Mapping Data Flow)」です。この機能を使用することで、データエンジニアリングに関する高度な専門知識を持たなくても、複雑なデータ変換を視覚的に設計し、実行することが可能になります。

モニタリング機能

データ統合プロセスを安定的に運用するためには、構築したワークフローの実行状況を継続的に監視することが不可欠です。ADFは、この運用監視を強力にサポートする機能を提供しています。

パイプラインとアクティビティの状況をリアルタイム監視

ADFにおける「パイプライン」とは、データ抽出、変換、格納といった一連の処理を順序立てて実行するためのワークフローの単位です。そして、そのパイプラインを構成する個々のタスクが「アクティビティ」です。

ADFのモニタリング機能は、これらのパイプラインおよびアクティビティの構築・運用時に、その状況を監視するために使用されます。

実行状況の追跡

データ処理アクティビティやパイプラインの実行状況をリアルタイムで追跡し、成功したタスクと失敗したタスク を明確に把握することができます。これにより、問題がどこで発生しているかを即座に特定できます。

詳細なメトリック

実行時間、転送データ量、処理された行数など、詳細な実行メトリックを確認でき、処理のボトルネックを特定するのに役立ちます。

複数のツール連携による最適化

ADFの監視は、専用の監視画面だけでなく、Azureプラットフォームが提供する複数のツールと連携して実行できます。

特に Azure Monitor との連携により、アラート通知の設定や、実行ログの詳細な分析が可能になります。これらの包括的な監視データを利用することで、データ統合パイプラインのパフォーマンス最適化やコスト調整 につなげることが可能です。

Azure ETL(Azure Data Factory)のメリット

Azure Data Factory(ADF)をデータ統合基盤として採用することは、技術的なメリットだけでなく、コストや運用面においても企業に大きな恩恵をもたらします。

Azureのクラウドネイティブな特性を最大限に活かし、従来のETLツールが抱えていた課題を解決することで、データ活用を加速させることができます。Azure ETL(Azure Data Factory)の主なメリットは以下の通りであり、それぞれについて以下で解説します。

- 初期費用が不要

- スキルに応じて開発可能

- サーバーレスでデータ統合可能

初期費用が不要

従来のオンプレミス型ETLツールを導入する場合、多くは高額なライセンス費用や初期構築費用、そしてサーバー機器の購入費用が発生します。しかし、Azure Data Factoryはクラウドサービスであるため、これらの初期費用やインフラへの先行投資は原則として不要です。

ADFは、利用した分だけ費用が発生する完全な従量課金制 を採用しています。

このモデルのメリットは、以下の点にあります。

柔軟な拡張性

データの処理量が増加した場合でも、サーバーレスなADFは必要な処理能力をクラウド上で柔軟かつ迅速に拡張できます。逆に処理量が少ない場合はコストが抑えられます。

スモールスタート

まずは小規模なデータ統合からスタートし、段階的に活用範囲を広げていくという、リスクの低い導入が可能です。

Azure Data Factoryの具体的な料金表は後述していますので、あわせてご覧ください。

スキルに応じて開発可能

Azure Data Factory (ADF) の大きなメリットの一つは、利用者のスキルレベルや専門性に応じて、データ統合パイプラインの構築方法を柔軟に選択できる点です。

ADFは、一般ユーザーから専門の開発者向けまで、幅広い利用層に対応する開発環境を提供しています。

一般ユーザー(ノーコード開発)

プログラミング知識がないビジネスユーザーでも、ドラッグ&ドロップ操作 だけでデータパイプラインを作成することが可能です。「マッピングデータフロー」機能などにより、複雑なデータ変換処理もコードを書かずに視覚的に設定できるため、データ活用のハードルが大幅に下がります。

専門の開発者(カスタムコード利用)

データエンジニアや開発者は、より高度で複雑なデータ統合ワークフローを作成する際に、PythonやScalaといった言語を使用したカスタムコード(例:Azure DatabricksやAzure Functionsとの連携)をパイプラインに組み込むことができます。これにより、きめ細かな要件に対応した柔軟な処理を実現できます。

サーバーレスでデータ統合可能

Azure Data Factory (ADF) は、まさにクラウドネイティブなサービスであり、サーバーレス のアーキテクチャが大きなメリットとなります。

これは、従来のETLツールのように、自社で物理サーバーや仮想サーバーを構築し、そのインフラストラクチャを維持・管理する作業が一切不要であることを意味します。ユーザーはインフラ管理のオーバーヘッドから解放され、データ統合ロジックの設計・開発という本質的な業務に集中できます。

ADFを通じて統合・変換されたデータは、最終的に Azure Synapse Analytics や Azure SQL Databaseなどのクラウドデータストアに格納(公開)されます。これにより、格納されたデータを Power BIなどのBIツールを用いて分析することが可能となり、迅速なビジネスインテリジェンス(BI)と意思決定サイクルが実現します。

クラウドETLツールを活用する理由について、さらに詳しく知りたい方は、以下の記事もあわせてご覧ください。

Azure ETL(Azure Data Factory)の料金形態

Azure Data Factory (ADF) のは、先にメリットとして解説した通り、初期費用が一切かからない完全な従量課金制 を採用しています。インフラストラクチャの維持管理費用は発生せず、データに対する処理(アクティビティ)と、パイプラインの実行時間 に応じて課金が行われます。

主な課金要素と料金(2025年11月時点の公式情報に基づく)は以下の通りです。

▼Azure Data FactoryV1

| 低頻度アクティビティ | 高頻度アクティビティ | |

| クラウドで実行 | 0.48ドル/月 | 1.00ドル/月 |

| オンプレミスで実行 | 1.20ドル/月 | 2.50ドル/月 |

▼Azure Data FactoryV2

| アクティビティのタイプ | 料金 |

| オーケストレーション | 1000実行で1ドル |

| データ移動アクティビティ | 1DIU(※)を1時間かけて移動して0.25ドル |

| パイプライン アクティビティ | 1時間あたり0.005ドル |

| 外部パイプライン アクティビティ | 1時間あたり0.00025ドル |

※上記の価格は目安であり、リージョン、利用プラン、為替レートにより変動する可能性があります。最新かつ正確な料金は必ずMicrosoft Azureの公式サイトでご確認ください。

※公式の料金ページでは日本円での表記に切り替えることが可能です。ただし、為替の影響で金額が変動し、メンテナンスコストが発生するため、USD表記を推奨します。

料金に関する説明・備考

Azure Data Factoryの従量課金モデルを最大限に活用し、コストを最適化するためには、課金の仕組みを深く理解しておくことが重要です。ここでは、料金に関する特に重要な留意点を3点解説します。

データフローがコストの中心となる

ADFのコストを検討する際、特に注意すべきなのが「データフロー (Mapping Data Flow)」の費用です。データフローは、データ変換ロジックを実行するために高性能なSparkクラスターリソースを使用するため、パイプライン全体のコストの大部分を占める傾向があります。

実行回数と実行時間の両方が影響

料金は、単にパイプラインを実行した「回数」だけでなく、データ移動や変換にかかったコンピューティングの「時間」にも基づいて計算されます。大量のデータを処理する場合や、複雑な変換ロジックを実行する場合、処理時間の短縮 がそのままコスト削減につながります。

スモールスタートに適したモデル

初期費用が不要で、小規模なオーケストレーションの実行費用が低く抑えられているため、まずは特定のデータ連携からスモールスタートしたい企業や、データ処理の負荷が変動しやすい企業にとって、非常にコスト効率の良いモデルと言えます。

Azure導入に向いている企業

Azure Data Factory(ADF)をはじめとするAzureのデータ統合サービスは、特定の環境や課題を抱える企業にとって、特に高い価値を発揮します。

本セクションでは、どのような企業がAzure ETLの導入に最も適しているかを具体的な特徴から解説します。また、自社のデータ環境にAzure ETLを導入するにあたり、Azureと連携可能なETLツールの選び方のポイントも併せてご紹介します。

データが様々なシステムに分散している企業

多くの企業では、データが特定の部門や機能に特化したシステムに分散して存在しています。例えば、顧客情報は顧客管理システム(CRM)に、従業員データは人事システムに、販売実績はERPに、といった具合です。

このようにデータがサイロ化している状態では、複数の情報を統合した全社横断的な分析を行うことが困難になります。

Azure Data Factoryやその他の強力なETLツールを活用すれば、この課題を解決できます。ADFは、先述の通り90種類以上のコネクタを通じて、複数のシステムからデータを効率的に抽出・集約 することが可能です。

分散していたデータを一箇所(例:Azure Synapse Analyticsなどのデータウェアハウス)に集約することで、データ間の関連性を見つけ出し、より深く正確なビジネスインサイトを得るための土台が整います。

データドリブンな意思決定を行いたい企業

ビジネスにおける競争力を高めるためには、経験や勘に頼るのではなく、データに基づいた客観的な事実(インサイト)から意思決定を行う「データドリブン」な組織体制への移行が不可欠です。

データドリブンな意思決定を実現するには、大量のデータを迅速に収集・加工し、分析可能な状態に整えるデータエンジニアリングの仕組みが重要となります。

データ処理の効率化

Azure Data Factory (ADF) は、ビッグデータに対応したスケーラブルな環境で、データのクレンジング、集計、変換といった複雑な前処理を効率的に行えます。これにより、分析担当者は「データの準備」ではなく「データの分析」に時間を集中できます。

ビジネス成果への貢献

迅速に分析基盤が整うことで、市場のトレンド予測、顧客行動の理解、業務プロセスのボトルネック特定などが可能となり、結果として業務の生産性向上やコスト削減 につなげることができます。

データドリブンな組織を構築する方法について、さらに詳しく知りたい方は、以下の記事もあわせてご覧ください。

まとめ

本記事では、Azure環境におけるデータ統合を効率化するクラウドETLサービス、Azure Data Factory (ADF) について、その基礎知識から具体的な機能、コスト、そして導入メリットまでを解説しました。

Azure Data Factoryは、インフラ管理の手間なく、豊富なコネクタとスケーラブルな処理能力によって、企業が抱える複雑なデータ統合の課題を解決します。

本記事を通じて、ADFの基本的な仕組みと特徴を理解し、自社のデータ活用戦略における最適なETLツールであるかどうかの判断にお役立ていただければ幸いです。

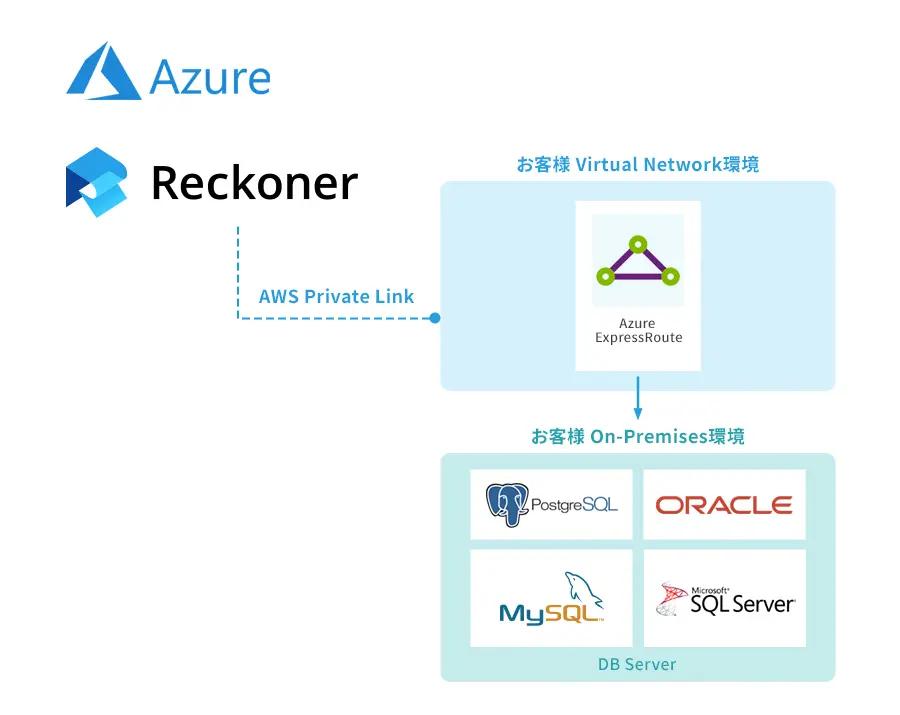

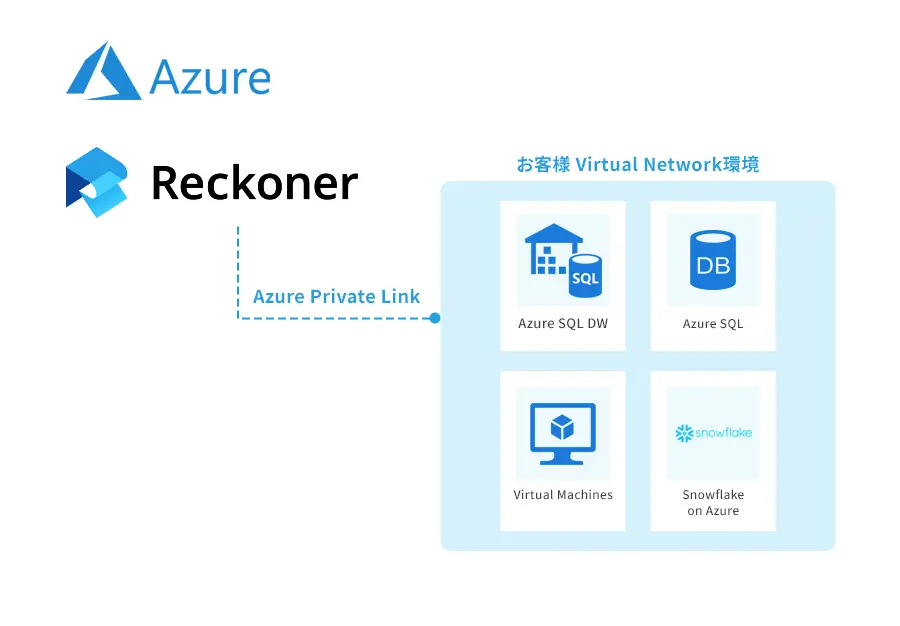

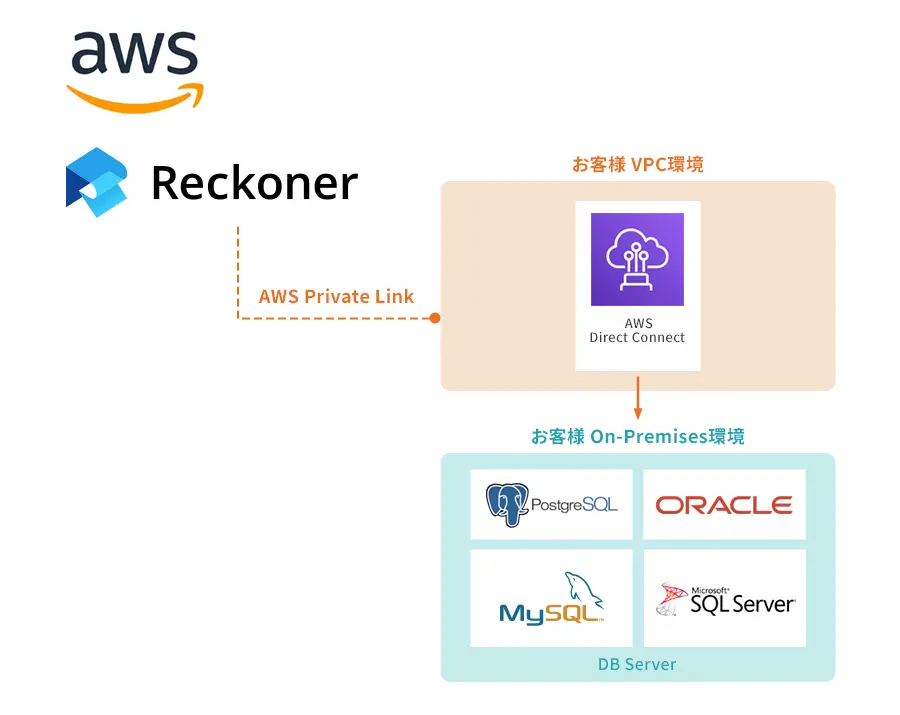

ETLツールはReckonerがおすすめ

Reckonerは、Azure環境を含む多くのデータソースからデータを取り込み、変換・統合することに特化したETLデータ統合プラットフォームです。

純国産で直感的なインターフェースを提供しており、ADFのData Flowと同様に、専門知識がなくてもデータ統合パイプラインを容易に構築・運用できます。

また、

国内サービスならではのきめ細やかなサポートと、日本企業のデータ連携ニーズに合わせた機能により、迅速かつ安定した導入・運用が可能です。

Azure環境でのデータ統合において、ADFと並行してReckonerの導入もご検討いただくことで、自社に最適なデータ統合ソリューションを見つけることができます。

Reckonerの機能や連携可能なデータソースの詳細については、こちらをご覧ください。

関連記事

関連記事はありません。