ETLツール「AWS Glue」とは?機能やメリット・デメリットを解説

現代のビジネスにおいて、データは最も重要な資産の一つです。しかし、社内の様々なシステムに散在するデータを集約し、分析可能な状態に整えるプロセスは、手作業では非常に手間と時間がかかります。

本記事では、データ活用を推進する企業担当者の方々へ向け、AWS Glueの主な機能やメリット・デメリットについて詳しく解説します。データの抽出・変換・格納を自動化するETLツール「AWS Glue」の活用方法と、導入時の注意点をご紹介します。

目次

- AmazonのETLツール「AWS Glue」とは?

- ETLツール「AWS Glue」の5つの代表機能

- AWS Glueを利用するメリット

- AWS Glueを利用するデメリット

- AWSユーザーがETLツールを利用しない場合とする場合の工数の違い

- 自社に合ったETLツールを選ぶポイント3選

- AWS Glueとあわせて比較検討したいETLツールReckoner

- AWSユーザーの利用多数: 14日間無料でお試し可能

AmazonのETLツール「AWS Glue」とは?

AWS Glueは、Amazon Web Services(AWS)が提供するフルマネージド型のETL(Extract・Transform・Load)サービスです。データの抽出、変換、ロードを自動化し、データ分析基盤の構築や運用を効率化します。

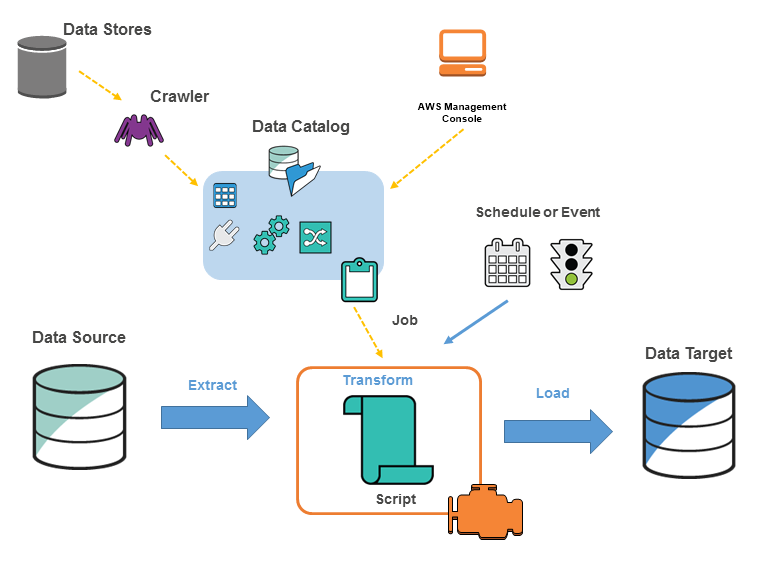

サーバやインフラの管理が不要なサーバレス構成で、ビッグデータ処理に必要なリソースはAWS側が自動でスケールします。また、データ構造を自動で解析するクローラーや、メタデータを一元管理するデータカタログ、ETL処理を実行するジョブやワークフローなど、ETLに必要な機能が標準で揃っています。

S3、RDS、Redshift、Athena などAWSの他サービスと連携しやすく、分析用のデータレイク・DWH(データウェアハウス)を運用したい企業に適したETLサービスです。

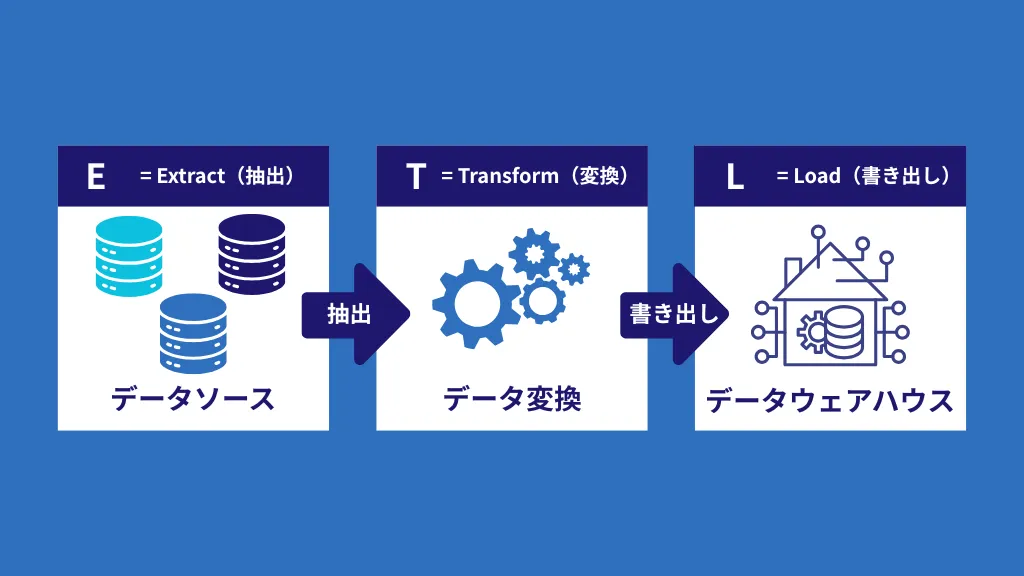

ETLツールとは?

ETLとは、「Extract(抽出)」、「Transform(変換・加工)」、「Load(格納)」の頭文字を取った略語です。これは、企業内にバラバラに存在するデータを一つに集め、分析しやすい状態に整えるための一連のプロセス、またはその仕組みを提供するツールを指します。

ETLツールは、以下の3つの機能で、データの統合管理を実現します。

Extract(抽出)

必要なデータを社内の様々なシステム(SaaS、データベース、ログファイルなど)から取得します。

各部門やシステムが独自のデータを抱え込み、組織全体での横断的なデータ活用が極めて困難になるのです。このサイロ化されたデータを短期間ですべて統合することは、ETLプロセスの構築に多大なリソースを割くこととなります。

Transform(変換・加工)

取得したデータを、分析に適した形式や、格納先のルールに合わせて整形、クレンジング(重複・欠損値の除去)します。

Load(格納)

変換・加工を終えたデータを、BigQueryのようなデータウェアハウスや他のシステムに書き込み(格納)ます。

ETLツール「AWS Glue」の5つの代表機能

ここでは、AWS Glueを利用するうえで特に重要となる5つの代表機能 —データカタログ, ETLジョブ, クローラー, Glue Studio, Glue DataBrewについて、それぞれの役割と特徴をわかりやすく解説します。

データカタログ

AWS Glueのデータカタログは、データの位置、構造、形式などのメタデータを一元管理する機能です。S3やRDSなどに保存されているデータが「どこに」「どのような形式で」存在するかを整理して保持し、Amazon Athena、Amazon Redshift Spectrum、Amazon EMRなど他のAWSサービスからも共通して参照・利用できます。データ基盤における”辞書”または”索引”として機能することで、データの検索性を高め、分析やETL処理を効率化します。

クローラー

AWS Glueのクローラーは、S3やRDSなどに保存されているデータを自動的にスキャンし、テーブル構造やスキーマを解析してデータカタログに登録する機能です。手作業でメタデータを定義する必要がなく、データの追加や変更があった場合も再スキャンによって自動的にカタログを更新できます。これにより、データソースの変化に柔軟に対応しながら、ETL処理やデータ分析の準備作業を大幅に効率化します。

ETLジョブ

AWS GlueのETLジョブは、データの抽出(Extract)・変換(Transform)・ロード(Load)処理を実行するためのスクリプト(PySpark/Python Shell)を管理・実行する仕組みです。Apache Sparkベースのサーバーレス環境で動作し、データ量に応じて自動的にスケールするため、大量データの処理も効率的に行えます。Glue Studioを使ったビジュアルな作成方法と、コードエディタでの直接編集の両方に対応しており、技術レベルや要件に応じて柔軟なETLパイプラインを構築できます。

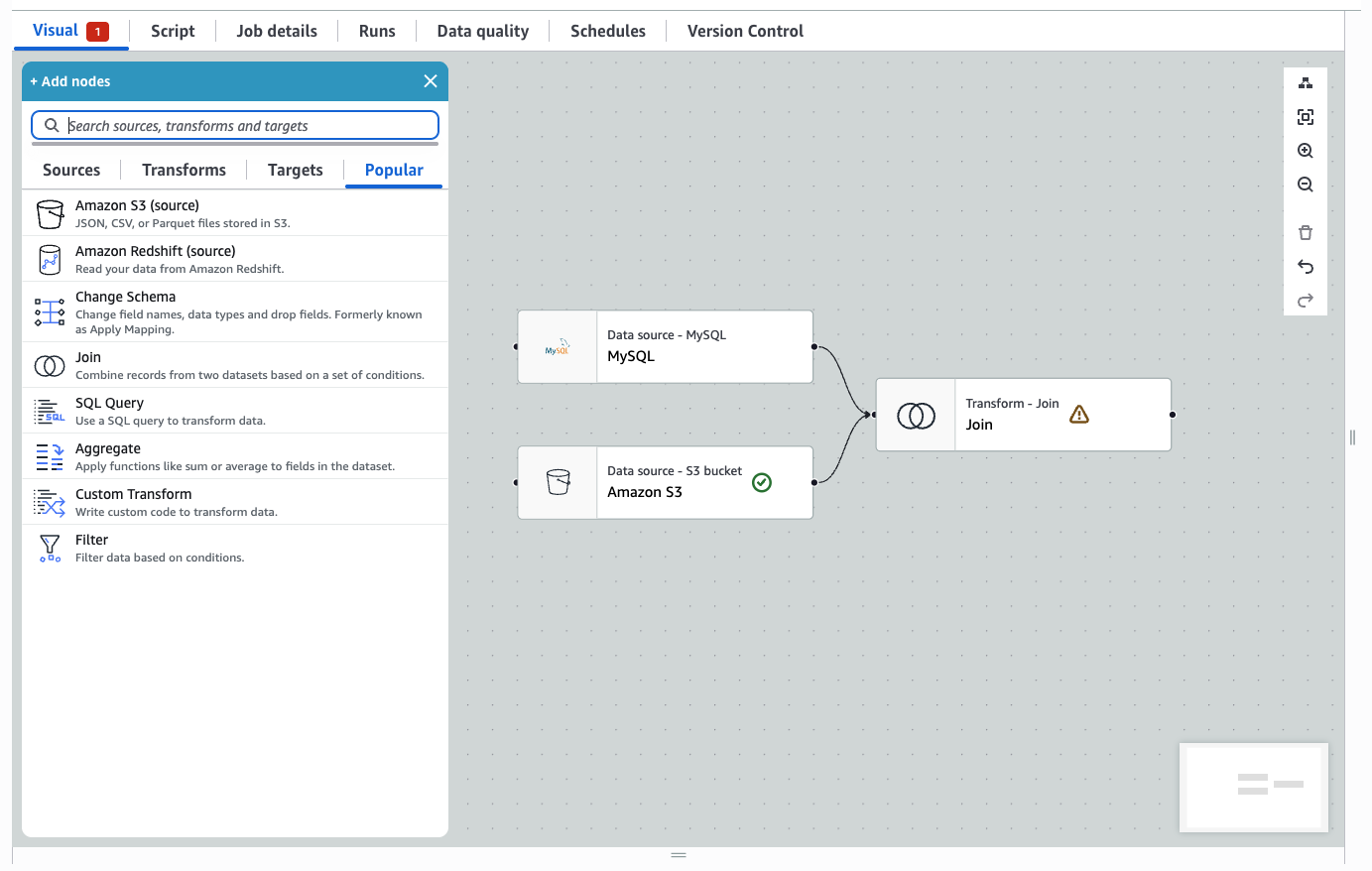

Glue Studio

AWS Glue Studioは、ETLジョブをGUIで直感的に作成・編集・管理できるビジュアル開発環境です。ドラッグ&ドロップ操作でデータソース、変換処理、ロード先を繋ぎ合わせることで、ノーコードでデータパイプラインを設計できます。データエンジニアだけでなく、データアナリストやビジネスユーザーでもETL処理を構築できるため、技術的な敷居が大きく下がります。生成されたPySparkコードは直接編集も可能なため、複雑なカスタム変換ロジックが必要な場合にも柔軟に対応できます。

また、AWS GlueではZero-ETL Integrationという機能も提供されています。Amazon RDSなどのデータベースやFacebook Ads、Salesforceなどの外部サービスから、ETLパイプラインを構築することなく、データを自動的にAmazon Redshiftなどの分析サービスへ連携できる機能です。

Glue DataBrew

AWS Glue DataBrewは、ノーコードでデータのクレンジングや前処理を行えるビジュアルなデータ準備ツールです。欠損値の補完、データ型変換、フィルタリング、正規化、重複削除など、250種類以上の組み込み変換処理をGUIで選択・適用できます。

SQLやPythonスクリプトを書く必要がないため、データアナリストやビジネスユーザーでも複雑なデータ整形作業を実行できます。これにより、分析や機械学習のためのデータ準備を大幅に効率化します。処理内容はレシピとして保存・再利用できるため、定型的なデータ準備作業の標準化にも役立ちます。

AWS Glueを利用するメリット

膨大なデータ(ビッグデータ)の処理が可能

AWS Glueはサーバレスアーキテクチャを採用しており、データ量に応じて自動的にリソースがスケールするため、数百万から数十億レコードといった大規模データのETL処理も安定して実行できます。Apache Sparkベースの分散処理エンジンにより、複雑な変換処理や大量データのバッチ処理を高速に実行できる点が大きなメリットです。

業務改善・コスト削減につながる

インフラの構築・運用が不要で、サーバのプロビジョニングやパッチ適用などのメンテナンスはすべてAWSが管理します。ETL処理を自動化することで、手作業によるデータ加工や複雑なスクリプト管理を削減でき、業務効率の向上と運用コストの削減を同時に実現します。また、使用した分だけの従量課金制のため、初期投資を抑えられます。

エンジニアの工数を削減できる

データカタログとクローラーによるスキーマの自動検出・登録、Glue StudioやDataBrewなどのビジュアルツールにより、コーディングにかかる時間を大幅に短縮できます。ETLパイプラインの設計から運用までに必要な作業が減少するため、データエンジニアはデータ基盤の設計やデータ品質の向上など、より戦略的で付加価値の高い業務に注力できます。

AWS Glueを利用するデメリット

従量課金により費用が想定以上に膨らむ可能性がある

AWS Glueは使用した分だけ課金される従量課金制のため、処理量やジョブ実行時間に比例してコストが上昇します。データ量の急増、非効率なETLロジック、ジョブの長時間実行などにより、想定を大幅に超える費用が発生するリスクがあります。事前のコスト試算、ジョブの最適化、Cloud Watchによる監視など、適切なコスト管理とリソース設計が不可欠です。

日本語の技術情報が限定的

AWS Glueは2017年にリリースされた比較的新しいサービスです。そのため、日本語での技術記事、ベストプラクティス、トラブルシューティング情報がまだ十分に蓄積されていません。英語のドキュメントやフォーラムを参照する必要があるケースも多く、学習コストが高くなる傾向があります。社内にAWSやデータエンジニアリングの知見が不足している場合、導入・運用のハードルが高くなる可能性があります。

日本語対応が不完全で使いづらい面がある

AWSマネジメントコンソールは日本語設定が可能ですが、AWS Glueのコンソール画面は完全に日本語化されておらず、英語表記が残っている箇所が多く見られます。また、ジョブ名やテーブル名に日本語(マルチバイト文字)を使用するとエラーが発生するケースがあるため、命名規則を英数字に限定する必要があります。日本語環境での利用を前提とする場合、これらの制約が開発・運用の障壁となる可能性があります。

AWSユーザーがETLツールを利用しない場合とする場合の工数の違い

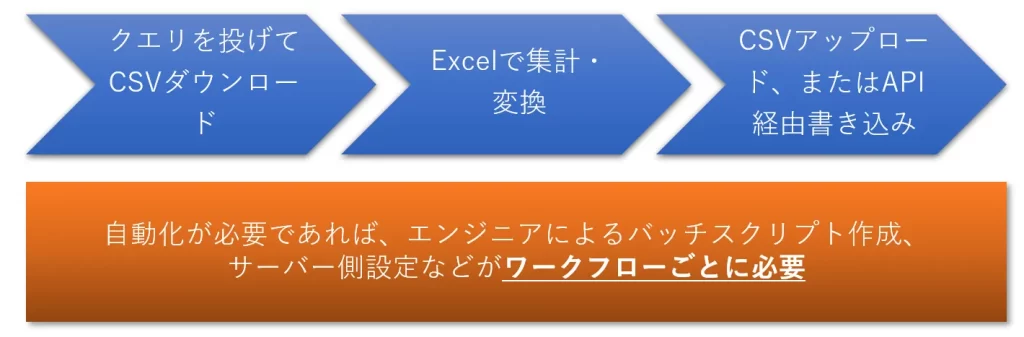

AWSユーザーがETLを利用してデータ変換を行った場合と、行わなかった場合で、どの程度工数に違いがあるのか見てみましょう。ここでは、RDSのデータベースのデータを変換し、SaaSにアップロードするまでの流れを比較してみます。

ETLを利用しない場合

- (処理1) SQLを発行しデータベースに問い合わせ、CSV形式でデータをダウンロード

- (処理2) Excelで読み込んで集計、変換(手作業)

- (処理3) SaaSにCSVインポートが可能であれば、アップロードを実施。もしインポートが不可能であれば、API経由でデータ書き込み。

これは完全に手作業で行う場合を想定していますが、部分的に自動化する場合でも、データ取得・変換/加工・データ書き込みを行うバッチスクリプトを一から作成する必要があります。さらに、サーバー側のホスティングや運用作業も発生します。当然、エンジニアの工数が必要です。また、これらの作業はワークフローごとに必要となります。

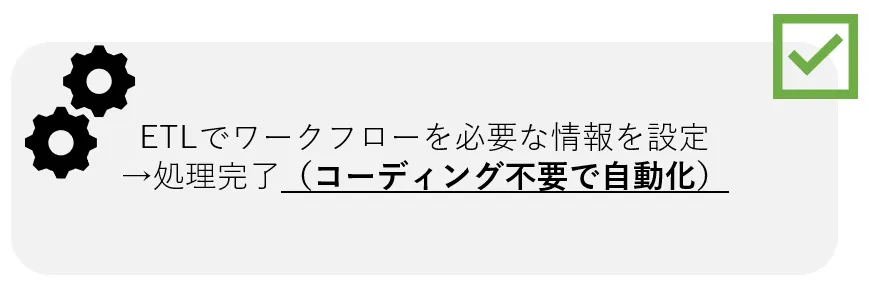

ETLを利用する場合

- (処理1) ETL上でワークフローに必要な情報(データ取得、データ変換・加工、データ出力)を設定。

ETLを利用する場合は、これだけで完了です。設定後は、毎日決まった時間に処理が自動実行されます。Reckonerのようなノーコード対応のETLツールなら、エンジニアの工数は一切不要です。

つまり、ETLツールを使えば、初回の設定さえ完了すれば、後は自動でデータ処理が実行されます。バッチ作成に貴重なエンジニアリソースを割く必要がなくなり、より重要度の高い業務に集中できます。

自社に合ったETLツールを選ぶポイント3選

ETLツールは多種多様で、それぞれ特徴やコスト体系が異なります。自社に最適なツールを選定するために、以下の3つの観点から検討することをおすすめします。

自社の課題を解決できるか

まず、自社が抱えているデータ連携・加工の課題を明確に整理し、候補となるETLツールがそれらを解決できるかを確認することが重要です。対応可能なデータソース(クラウド、オンプレミス、SaaS等)の種類、必要な変換処理の実現可能性、リアルタイム処理の要否、データ量への対応力などを基準に評価しましょう。単に機能が豊富であることよりも、自社の具体的なユースケースに適合しているかが重要です。

想定利用者のスキルレベルに適しているか

ETLツールによって求められる技術レベルは大きく異なります。コーディング必須のツールもあれば、GUIでノーコード操作できるツールもあります。実際に運用を担当するメンバー(データエンジニア、データアナリスト、ビジネスユーザーなど)のスキルセットを踏まえ、無理なく使いこなせる操作性かどうかを確認しましょう。ノーコード対応ツールを選択すれば、非エンジニアでも運用でき、属人化のリスクを低減できます。

期待する費用対効果を実現できるか

初期導入コスト、ライセンス費用、運用コスト(人件費含む)と、それによって得られる業務効率化、工数削減、データ活用による売上向上などを総合的に評価することが不可欠です。現在の処理量だけでなく、データ量の増加やユースケースの拡大といった将来的な拡張性も考慮に入れ、中長期的な視点で費用対効果が最大化できるツールを選定しましょう。無料トライアルやPoCを活用して、実際の効果を検証することも有効です。

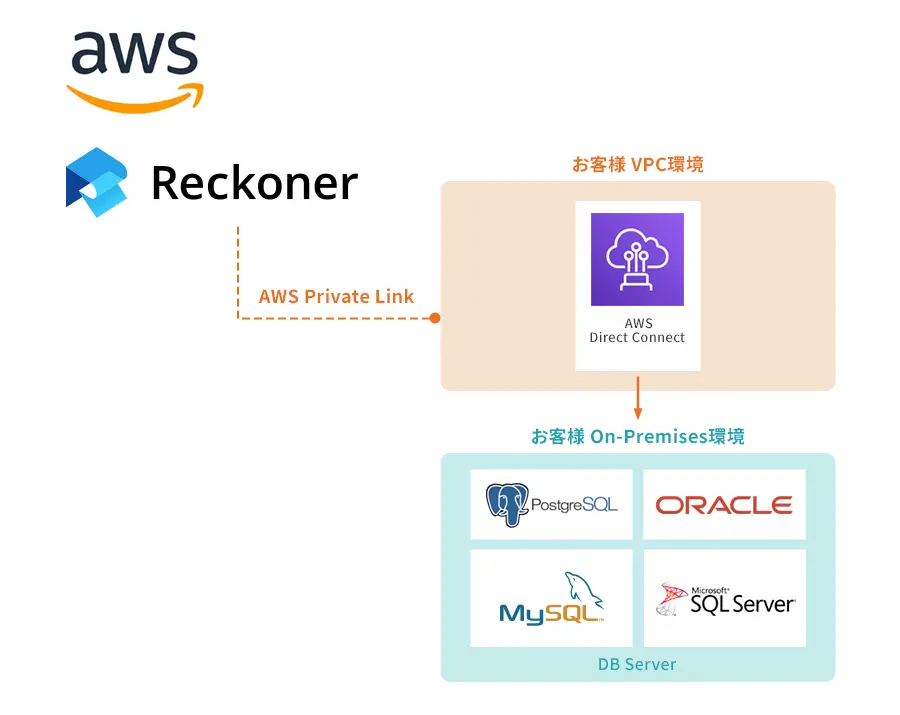

AWS Glueとあわせて比較検討したいETLツールReckoner

ここまでで、AWSユーザーがETLを利用してデータ関連業務を分析すべき理由について説明いたしました。ここでは「他のETL」ではなく、「当社のETLであるReckoner」を使うべき3つの理由について、説明いたします。

1.コーディング不要・エンジニア不要

一部のETL製品は優れた機能を持ちながらも、細かな処理設定にプログラミングが事実上必要です。このような製品では、ワークフローを作成・編集するたびにエンジニアへの依頼が発生し、工数がかかるだけでなく、迅速な分析が困難になります。

一方、Reckonerは直感的なGUIを備え、コーディング不要でワークフローの作成・編集が可能です。実際に、Reckonerユーザーの多くは非エンジニアで、プログラミングなしで日々のデータ処理を完了しています。

2.スケーラビリティ(ビッグデータを処理可能)

Reckonerは、小規模な処理から大規模な処理まで、ユーザーの処理規模に応じたプランを提供しています。処理数が少ない場合は、限られたワークフローのみを安価に利用できます。一方、大規模な処理や頻繁な処理が必要な場合は、テラバイト級のデータを短時間で処理できるスケーラビリティを備えています。

オンプレミス型のETLでは、ETLサーバの処理性能がデータ処理速度の上限となります。しかし、Reckonerは100%クラウドネイティブの製品のため、処理量が増えても柔軟に対応できます。

3.日本語対応

ETLツールに限らず、海外由来のSaaS製品は、製品の活用とサポート面で3つの弱点があります。

1点目: ドキュメントが英語

海外由来のSaaSツールは、ドキュメントが基本的にすべて英語で記載されており、日本語訳されているのは一部のみ(または全く翻訳されていない)のが一般的です。そのため、英語のドキュメントを読み解きながら利用を進める必要があります。つまり、ノーコードの製品であっても、利用のハードルが高くなってしまいます。

2点目: 代理店経由のサポート

海外メーカー製品の場合、販売代理店を経由したサポートが多く、情報の質と鮮度に課題が生じることがあります。IT製品の販売代理店は多数の製品を扱っているため、個々の製品に十分なサポート体制を構築できないことが一般的です。その結果、「回答内容が古いバージョンに基づいていた」「代理店担当者の理解が不正確だった」といった問題が発生する場合があります。

り対応が遅れるケースがあります。例えば、アメリカ西海岸のメーカーの場合、業務開始時間が日本時間の夕方に当たるため、「質問しても1日に1往復程度しかやり取りが進まない」ということも少なくありません。

また、海外メーカー製品の問題を問い合わせる際、「発生した事象や運用の詳細を英文で記述する必要があり、問い合わせ自体に時間がかかった」という事例もあります。

Reckonerは日本で開発された製品で、ドキュメントもすべて日本語で用意されています。メーカーが直接提供しているため、販売代理店との「情報格差」という問題は発生しません。さらに、日本時間で営業しているため、問題の迅速な解決が可能です。

なお、日本語でのチャットサポート、メールサポートに対応しておりますので、日常利用における「ちょっとした疑問や質問」なども、手間をかけずに気軽にお問い合わせいただけます。

AWSユーザーの利用多数: 14日間無料でお試し可能

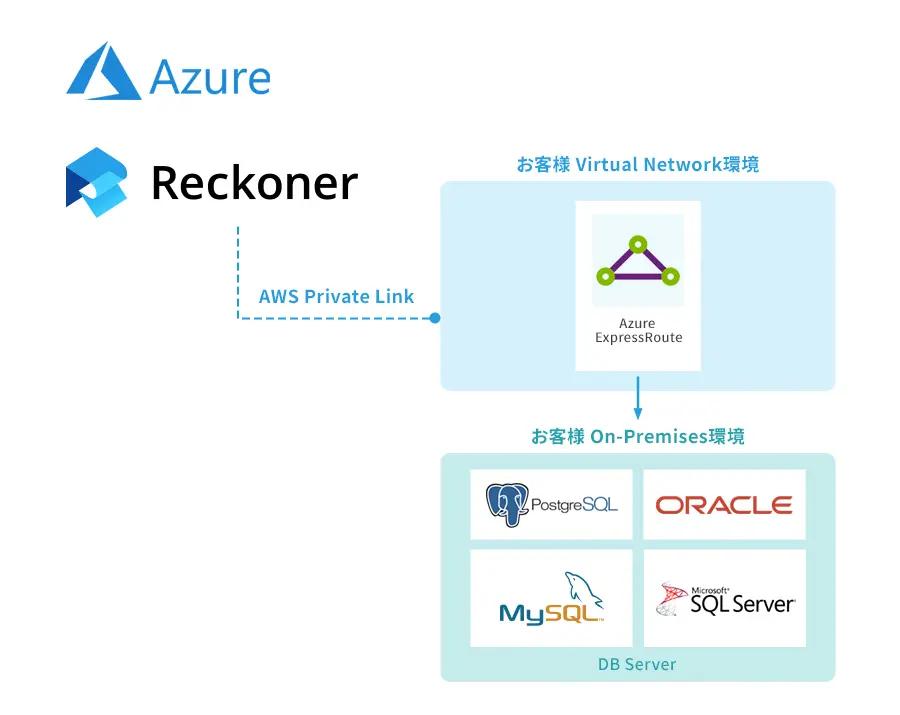

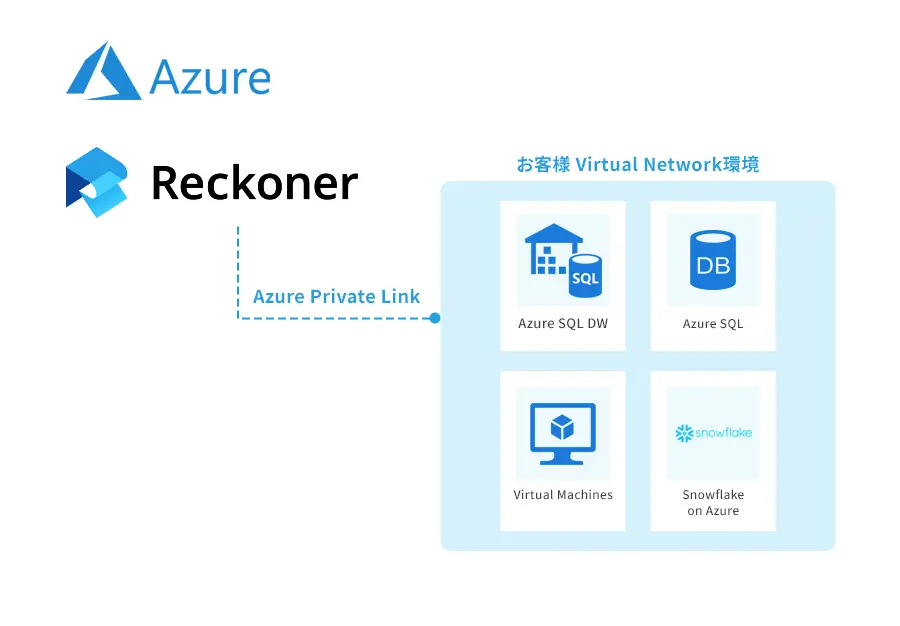

当社のETL製品であるReckonerは、特にAWSユーザーから高い支持を受けております。毎日、多くのReckonerユーザー様がRDSやS3、Redshiftからデータを取得し、自動で変換・加工を行い、より優先度の高い業務にリソースを投下されています。

Reckonerは14日間でご利用頂けますので、ぜひ「1つのETLワークフローを作る」ところから、ご評価ください。「作り方が分からない」「データが多すぎて収拾がつかない」といった相談も大歓迎です。

ETLツールについて詳しく知りたい、ETLツールの選び方を知りたいという方はこちらの「ETLツールとは?選び方やメリットを解説」をぜひご覧ください。