BIツール導入で「データ準備」が8割?分析の挫折を防ぐETL活用術

「経営判断を迅速にするためにTableauやPower BIを導入したはずが、現場はエクセルの加工作業に追われている」

「SFAとkintoneの数値が合わず、どちらが正しいか議論するだけで1時間終わる」

もし貴社のDXプロジェクトでこのような現象が起きているなら、それはデータ準備の重要性が見落われているからかもしれません。

多くの企業がBIツール導入時に直面する「分析まで辿り着けない」という課題。その原因の多くは、ツールの使い方ではなく、分析の前工程であるデータの準備にあります。

BIプロジェクトが失敗する最大の原因「データ準備の罠」とは? 本記事では、その解決策となる「ETLによる自動化」を解説します。エンジニアの手を借りず、現場だけで「データが勝手に集まり、整う仕組み」を作る具体的なステップをご紹介します。

💡30秒で読める!この記事のポイント

- 「分析前の準備」が挫折の8割: BIツールが活用されない最大の原因は、データの収集・加工に時間がかかりすぎていることにあります。

- 「Excelバケツリレー」の限界: 手作業によるデータ加工は、工数増・ミス・属人化を招き、DXの足を引っ張ります。

- 「ETL」で自動化を実現: 複数のSaaS(Salesforce, kintone等)のデータを「下ごしらえ」し、自動でBIに繋ぐ仕組みが不可欠です。

- エンジニア不要の「Reckoner」: ノーコードツールを使えば、現場主導でデータ集計を自動化し、分析に集中できる環境が手に入ります。

目次

分析プロジェクトの「8割」はデータ準備で終わる現実

データ分析の世界には、「80対20の法則」と呼ばれる有名な経験則があります。それは、「データ分析プロジェクトの時間の80%はデータの収集・整形・加工に費やされ、実際に分析や洞察に使われる時間はわずか20%に過ぎない」というものです。

なぜBIツールに直接データを入れると失敗するのか

近年のBIツールは高機能ですが、あくまで「データを可視化する」ためのツールです。「汚れたデータ」や「構造がバラバラなデータ」を自動的に綺麗にしてくれる魔法の杖ではありません。

例えば、Salesforceに入っている「商談データ」と、kintoneで管理している「予算データ」を突き合わせて予実管理をしたいとします。

| 項目 | Salesforce | kintone |

|---|---|---|

| 日付データの例 | 2024-04-01 (日付型) | 2024/4/1 (文字列) |

| 会社名の例 | 株式会社A (全角統一) | (株) A (半角・略称混在) |

このように形式が異なるデータをBIツール上で無理やり結合しようとすると、エラーが頻発するか、動作が極端に重くなります。結果、担当者はBIに入れる前にデータを手動で修正することになります。

現場を疲弊させる「Excelバケツリレー」のコスト

BIツールを導入したのに、現場では以下のようなフローが発生していませんか?

- SalesforceからCSVをダウンロード

- kintoneからCSVをダウンロード

- ExcelでVLOOKUPを駆使してデータを結合・加工

- 加工済みのファイルをBIツールにアップロード

これでは、DXどころか業務が増えただけです。しかも、この作業は「レポートが必要になるたび」に発生します。属人化したExcel作業はミスを誘発し、経営層が見るダッシュボードの数値に対する信頼性さえも損なってしまいます。

| 項目 | 手作業(Excelバケツリレー) | ノーコードETLによる自動化 (例:Reckoner) |

|---|---|---|

| データ更新の作業時間 | 数時間〜数日(毎回発生) | 数分 |

| データの鮮度 | 加工が終わるまで古いまま | 常に最新(自動更新) |

| 正確性 | ヒューマンエラーのリスク大 | ミスゼロ(ルール化) |

| 属人化 | 「職人」以外は触れない 引き継ぎが困難・ブラックボックス化 | 誰でも運用・修正可能 |

もし毎月10種類の集計やレポートを作成しているなら、年間で数百時間の工数が『ただの準備』に消えている計算になります。この時間を分析に回せるとしたら、どれほどのインパクトがあるでしょうか?

「分析できるデータ」を作るためのETLという解決策

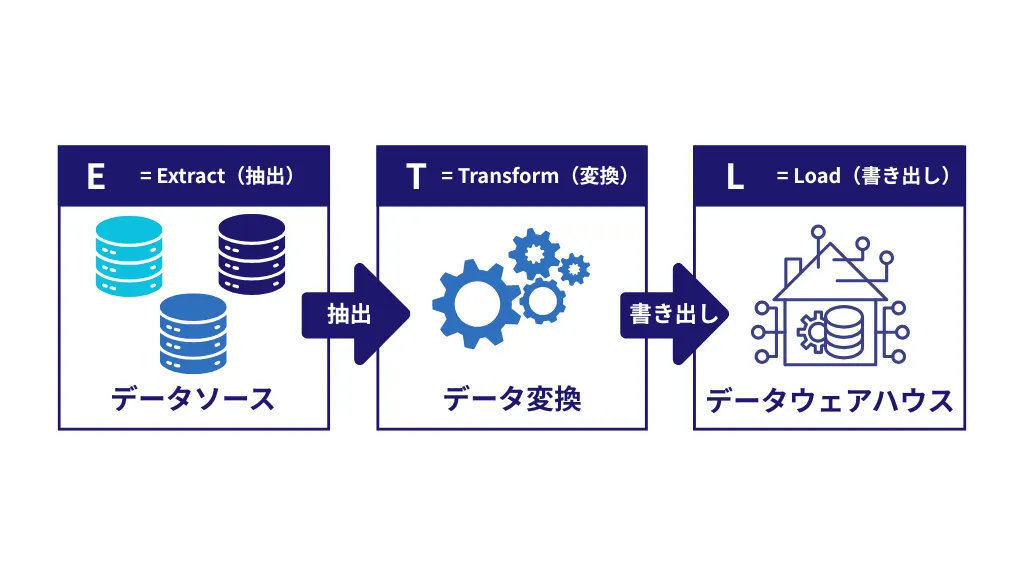

この状況を打破するために必要なのが、ETL(Extract, Transform, Load)ツールによるデータパイプラインの構築です。

ETLとは、データを抽出(Extract)し、分析しやすい形に加工(Transform)し、データウェアハウス(DWH)やBIツールへ書き出す(Load)処理のことです。料理で例えるなら、BIが「盛り付け(提供)」であるのに対し、ETLは「下ごしらえ」にあたります。

参考:ETLとは?必要性や選び方、ETLがないと生じる問題をわかりやすく解説

SFA(Salesforce)やkintoneのデータはそのままでは分析できない

特にBtoB企業のSalesOps(営業企画・営業推進部門)において、データソースはSalesforceやkintoneなど複数にまたがることが一般的です。

- 名寄せ: 表記揺れのある顧客名を統一する

- データクレンジング: 空白データや異常値を除外する

- 統合: 複数のシステムIDを紐付ける

これらの「下ごしらえ」をETLツールに任せることで、人間は単純作業から解放されます。夜間に自動でデータが整形され、朝出社した時には最新の正確なデータがBIツールに反映されている状態こそが、本来あるべき姿です。

エンジニアに頼らずに「データパイプライン」を作る意味

従来、ETL処理の実装には専門のエンジニアによるプログラミングが必要でした。しかし、変化の激しい営業現場において、分析軸を変えるたびにエンジニアへ修正依頼を出すのではスピード感が損なわれます。

「現場主導」でデータの加工ルールを変更できること。これが、これからのデータ活用における必須条件です。

参考:GA4とSalesforceのデータをGoogle BigQueryに入れLooker Studioで可視化

Reckonerで「データ準備」を自動化し、分析そのものに時間を割く

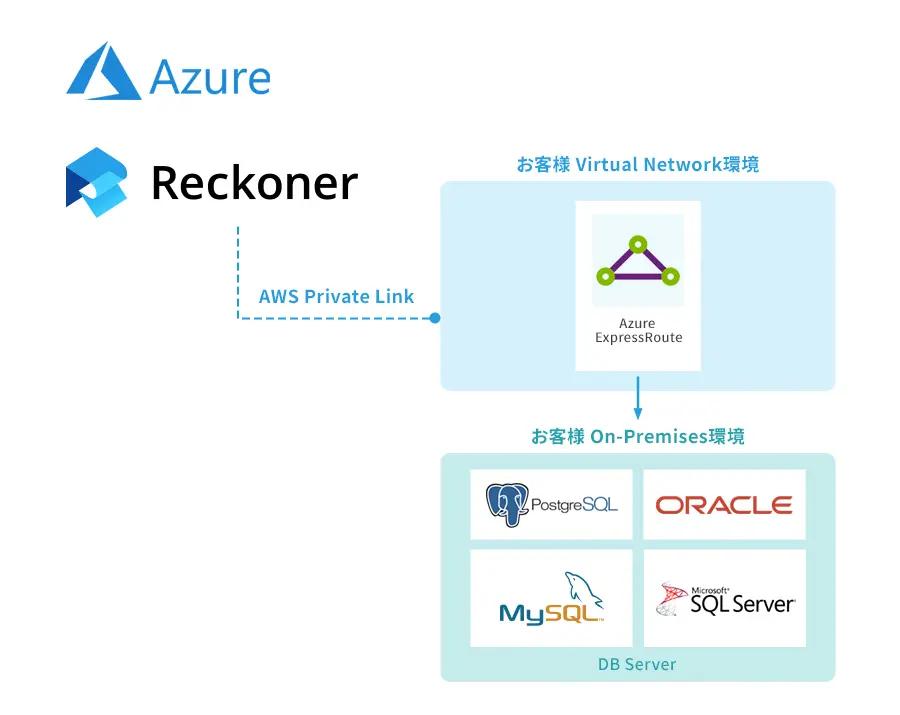

Reckonerは、プログラミング知識がなくても使えるクラウド型ETLツールです。特にSalesforceやkintoneとの連携に強みを持ち、ドラッグ&ドロップの直感的な操作でデータの加工フローを構築できます。

株式会社マイナビ様の事例

69の組織を巻き込み、全グループ会社で加速するDX戦略! Reckoner導入で1300以上のワークフロー構築、作業時間も90%短縮!

株式会社マイナビのデータ活用推進チームでは、「非エンジニアでもデータを扱える環境(データ民主化)」を目指してReckonerを導入しました。

特にマーケティング部門におけるWebサイト分析レポートの作成業務では、従来Excelを使った手作業でのデータ加工に「毎回1時間」を費やしており、属人化と作業ミスが課題となっていました。

Reckoner導入後は、元データをGoogle Driveに格納するだけで、自動的にレポート用データが生成されるワークフローを構築。

結果として、データ準備にかかる時間はわずか「5分」へと短縮され、創出された時間はより深い分析業務へと充てられています。現在では69の組織、1,300以上のワークフローが現場主導で稼働しており、エンジニアに依存しないデータ活用文化が定着しています。

導入効果

- 作業時間を90%短縮(60分 → 5分)

- 1,300以上のワークフローが現場主導で稼働

- エンジニア依存からの脱却に成功

※インタビュー全文は以下からご覧いただけます

参考記事:株式会社マイナビ様導入事例インタビュー

まとめ

営業データ活用を成功させるための秘訣は、現場に「二重入力してでも正しく入れろ」と強制することではありません。「現場が使いやすいツールに入力すれば、システムが勝手に統合してくれる」という環境を作ることです。

- データの分断を解消する:kintoneとSalesforceを自動で繋ぎ、二重入力を撲滅する。

- データの純度を高める:クレンジングを自動化し、分析の精度を上げる。

- リアルタイムな意思決定:作業時間をゼロにし、常に最新のデータで戦略を練る。

営業データの自動連携なら「Reckoner(レコナー)」

データの壁を壊し、営業組織を「データ駆動型」に進化させる最短ルートが、ノーコードETLプラットフォームのReckonerです。

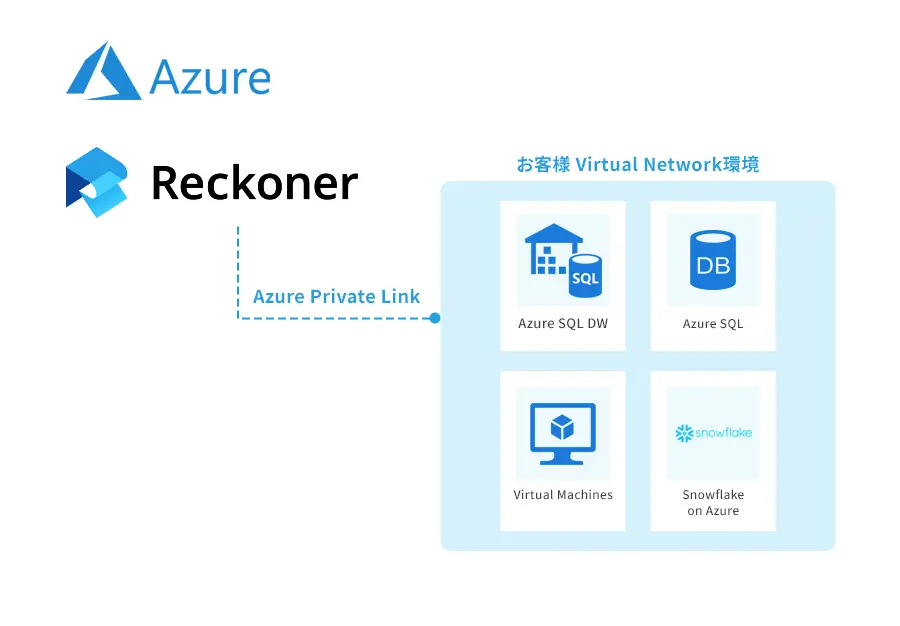

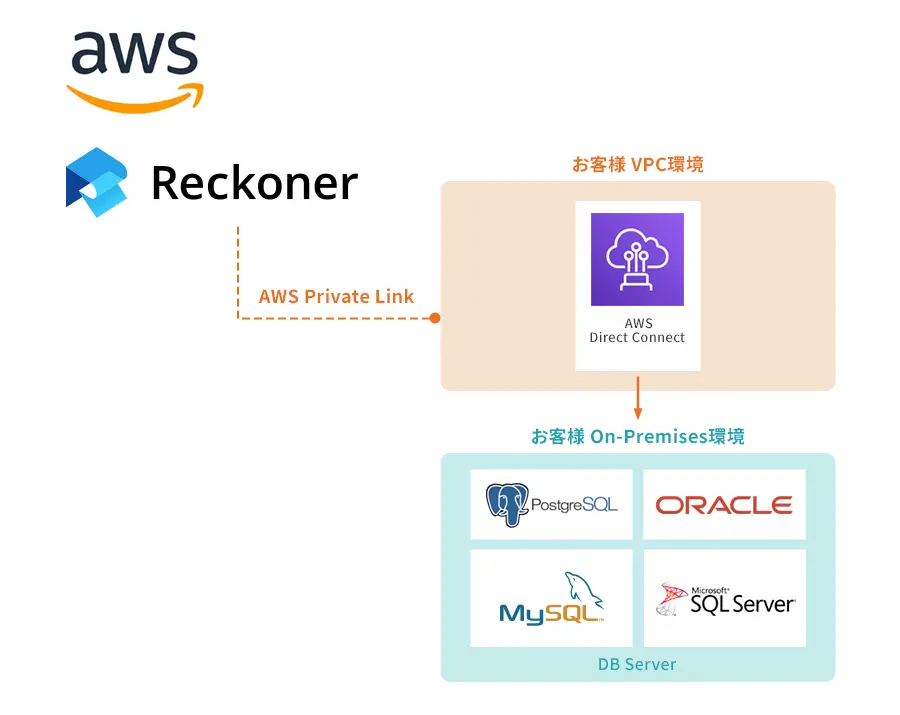

Reckonerは、Salesforceやkintoneを含む100種類以上のSaaS・データベースに対応。プログラミング不要で、データの抽出からクレンジング、統合までを「3ステップ」で完結させます。

手作業の限界を感じている方は、ぜひお問合せください。