データサイエンティスト導入と課題について理解する [データサイエンティストはなぜ活躍できないのか]

データサイエンティストの導入は、データ管理ならびにデータ分析において「万能薬」「救世主」のように考えられている場合があります。しかし、どれほど優れた人材を投入しても、優れた人材が活躍できる基盤がなければ「宝の持ち腐れ」となります。以下で解説します。

本記事では、以下を参考に執筆を行っております。

(参考元: Atwal, Harvinder “Chapter 1. The Problem with Data Science.” In Practical DataOps: Delivering Agile Data Science at Scale, edited by Atwal, Harvinder. Isleworth, UK: APRESS, 2020.)

目次

データサイエンティスト導入への期待

データサイエンティストの導入により、以下のような効果を発揮したという組織があるのではないでしょうか。

- Netflix: レコメンデーションアルゴリズムの活用により、解約率の減少による毎年10億ドルの収益確保

- Monsanto: 物流の改善を主導し、年間1,400万ドルのコスト削減とCO2排出量を350メートルトン (MT) 削減

- Deepmind: AlphaGoで知られる、Alphabet傘下のDeepmindは、病院と提携して、AIシステムを開発し、50以上の眼科分野の世界トップレベルの治療を実現

多くの組織では、データサイエンティストに活路があると判断し、多額の投資を行っています。具体的には、世界のビッグデータおよびビジネスアナリティクスの市場規模は、2020年に1,980億ドル、2030年には6,841億ドルに達すると予測されています。

データサイエンティスト導入の現実

こうした事例とは裏腹に、実際にデータサイエンティストを導入した組織の多くは実績を残せていません。データ量の増加、データ関連ソリューションへの支出増加、テクノロジーとアルゴリズム改善を行っても、生産性向上に寄与できていないのです。

Forrester社が発表した調査では、分析モデルやアルゴリズムから得られる「インサイト」を、自社の業務モデルに組み込み、意思決定の質を向上させた「インサイトリーダー」企業は、わずか22%であると報告されています。

では、なぜこれほどまでに実現が困難であるのか、以下で見ていきましょう。

データ品質

IoTデバイスセンサーやモバイル機器、非構造化データ、イベントログなどによりデータ量は増加し、この増加に対応するようにデータサイエンティストが分析を行える場面が増加していると、一般的には考えられています。

しかし、そもそも足元の問題が解決していない組織が多くあります。具体的にはデータ品質です。

Figure Eightが作成したデータサイエンティストレポートでは、データサイエンティストの55%が「データトレーニングの質および量が障害になっている」と回答しています。また、Kaggleの2017年の調査によると、データサイエンティストの最大の障壁は「ダーティーデータ(データ品質)」であるとされています。

- 参考記事:DataOpsの未来とトレンド

誤ったテクノロジー選択

技術の進化により、これまで困難だった処理が容易に実施できるようになる、優れたUIによりユーザーからの分析が可能になる、自動化が促進されると期待されています。

しかし、これらはすべて「正しいテクノロジーを選択した場合のみ享受可能」です。例えば、データサイエンティストという人材への投資を行っているものの、時代遅れの、誤ったソリューションへの投資を行った場合、データサイエンティストが必要な分析が行えない、または分析に膨大な工数がかかるといった事態が発生します。

経験不足なデータサイエンティスト

Kaggleの2021年の調査「State of Data Science and Machine Learning survey」によると、米国のデータサイエンティストの年齢構成では全体の半数以上が22歳から34歳でした。また学歴構成は、データサイエンティストは10.8%が博士号、39%が修士号、38.1%が学士号となっています。

学歴でのみ能力を判断するのは適切ではないかもしれませんが、「データサイエンティスト」と称するに値するほどの、専門的な教育・研究実績がない「データサイエンティスト」が多いともいえます。Kaggleの調査データによると、データサイエンティストに対して「これまで何年間プログラミングの経験があるか」という質問の回答は、多いものの順に、1~3年(30.3%)、1年未満(22.6%)、3~5年(15.6%)となり、3年未満のコーディングの経験者が半数以上を占めています。

また、データサイエンティスト組織のマネージャー人材も不足しています。Kaggleの調査データでは、プログラム・プロジェクトマネージャーは全体の2.5%にとどまっています。このため、「経歴が立派な人材を採用したが、経験不足により力量が発揮できなかった」「データサイエンティスト組織において、適切なマネジメントが行われなかった」というリスクがあるといえます。

プロセス

KDnuggets社の調査では、データマイニングのプロセスにおいて、43%が業界標準であるCRISP-DMを用いたとされています。また、SASが提唱するSEMMAや、KDD(Knowledge Discovery Databases)などもあります。

しかし、これらデータマイニングプロセスの問題は、実際よりかなり単純化されているという点です。MVP (Minimum Viable Product、最小限の実行可能な機能を持つ製品サービス)、ユーザーや顧客からのフィードバック、製品サービスを価値あるものとするための反復作業(確認作業など)が軽視されています。

これらのプロセスをそのまま適用するだけでは、コミュニケーションやコラボレーションが乏しい状態で作業が完了することになり、失敗の大きな原因となります。よって、機敏性、反復性、標準化、協調性などを踏まえたプロセス、例えばMicrosoftが提唱するTeam Data Science Process (TDSP) などを採用することも有用です。

組織文化

米国経済紙フォーチューン社が、700人以上の組織の上級管理職に行った調査では、彼らの61%がハードな分析よりも人間の洞察を頼りにすると回答しています。上級管理者の約3分の2(65%)は、ビジネス環境がますます複雑化し、純粋に「機能的」な要素(例えば、コスト、品質、効率など)に基づく意思決定が難しくなっていると回答しています。

こうした状態では、データサイエンティストが高度な分析を行い、次のアクションを提言したとしても、経営陣から「我々の感や経験では、その方法は役に立たない」といった理由で却下される可能性があります。

データ品質向上のためのETL

これまで、なぜデータサイエンティストは活躍できないのかについて解説いたしました。

そして、データサイエンティストが活躍する場を大きく狭めてしまう最も大きな理由が、データ品質であることも解説いたしました。

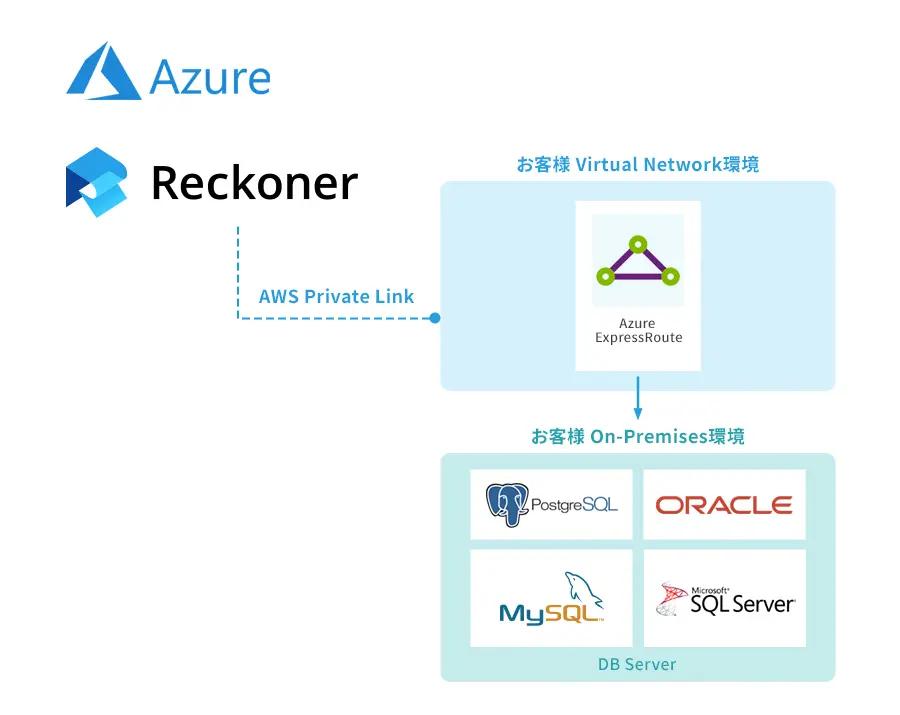

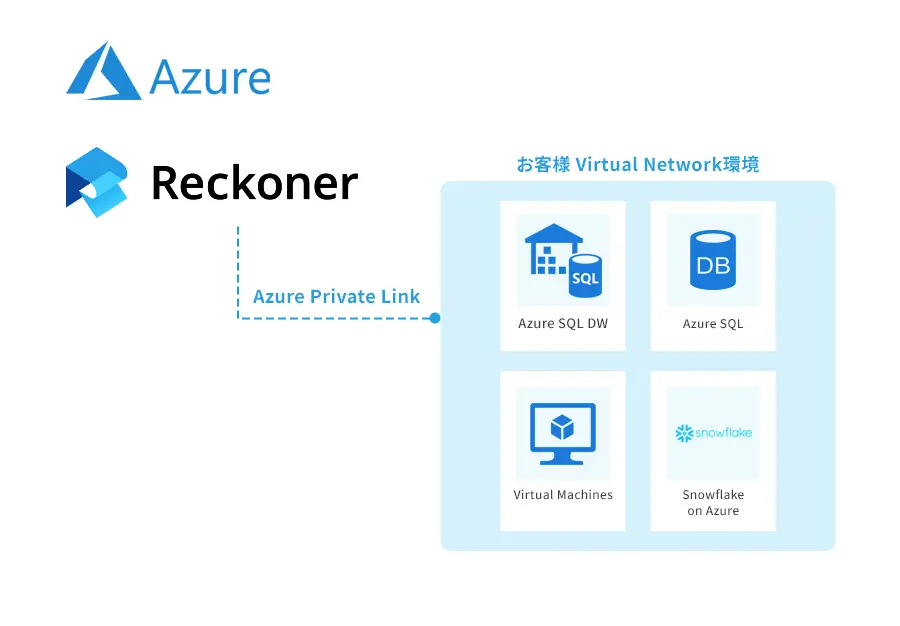

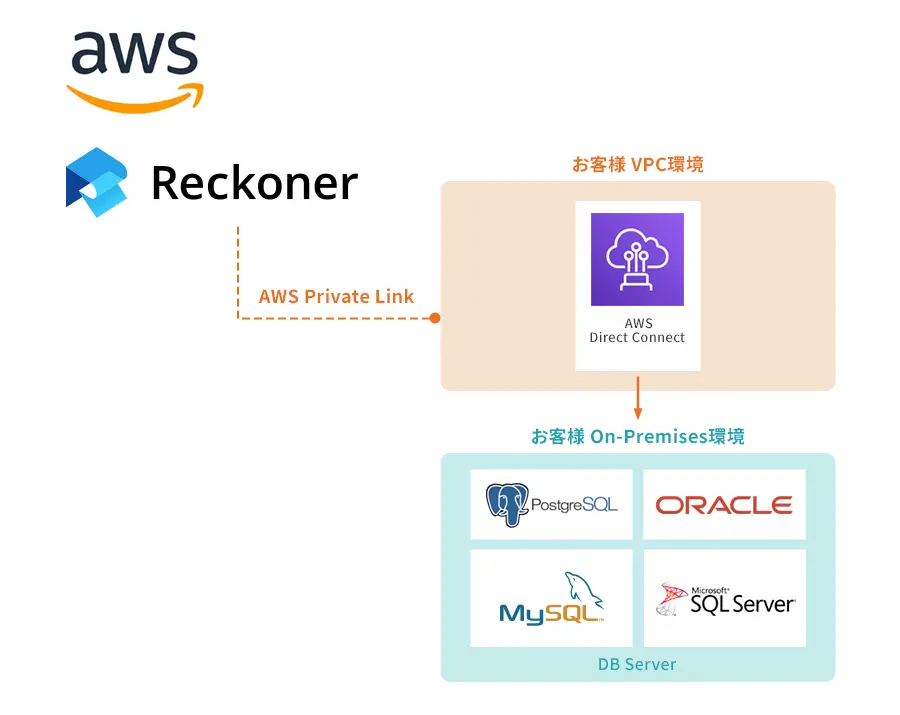

このデータ品質向上のために欠かせないツールに「ETL」があります。データソースに接続し、データを必要な形式に変換し、出力するツールで、「多くのバラバラのデータを、データ統合を通じて分析可能にする」役割を果たします。

データサイエンティストを採用したものの、そもそもデータサイエンティストが活躍できる状況が揃っていない場合は、まずはデータ品質から着手するのがよいでしょう。当社は、提供するETL製品であるReckonerを通じ、あらゆる組織のデータ品質向上を支援いたします。

関連記事

関連記事はありません。