データ収集基盤にかかるコストを考える

もしあなたの会社がSalesforceやMarketo、またはkintoneなどの業務アプリケーション(SaaS)を導入しているなら、データを取得し、分析することで、より効果的にビジネスのパフォーマンスを計測することができます。

それぞれのSaaS内にもダッシュボード機能はありますが、より柔軟に、より汎用的なデータ分析を実現するためにはスプレッドシートやデータウェアハウスへ出力することが必要になるでしょう。

また、もし大量の顧客データを自社で保有していて活用し切れていないならそれは宝の山かもしれません。

SaaS、データベース、大量のExcelデータなど、自社に散らばるあらゆるデータを活用するためにはどのような基盤が必要なのか。データ収集基盤の構築におけるコストについて考えてみます。

目次

データソースの追加ごとにかかる開発コスト

SaaSの普及に伴い、API経由でのデータ取得も昔より容易にできるようになりました。

しかし、各社が提供するAPIはフォーマットも提供方法もバラバラであるため、一つずつ仕様を調査し、個別に設計しながら開発する必要があります。

そこで、実際に複数のデータソースからデータを収集する基盤の構築を考えてみます。

まず平均して1データソースの開発に最大6週間(1.5ヶ月)かかるとします。

また、各データソースはソフトウェアベンダーによる仕様変更により、今まで使えていたAPI連携が使えなくなる可能性があるため、一度作って終わりではなくメンテナンスする必要があります。

このAPIの仕様変更に伴うアップデート作業を年間大体2週間ほどかかるとすると、1データソースにつき8週間の開発期間が必要ということになります。

エンジニアの人件費を月100万と仮定した場合、1データソースを連携させるために、

100万円 * 2ヶ月 = 200万

年間で200万円かかる計算になります。

仮に連携させるデータソースが5つあった場合は、

200万 * 5 = 1000万円

合計1000万円ものコストを支払う計算になります。

実際には、エンジニアの採用やマネジメントコストなどがかかるためこれ以上の費用がかかるケースが多いのではないでしょうか。

データの加工・整備にかかるコスト

生のデータはそのままでは分析も活用もできないため、適切に加工して「使えるデータ」に整備する必要があります。

データ加工における代表的な作業として、データクレンジング、データ結合、データ変換などがあります。

データクレンジングとは、データレコードの重複排除、データ内の誤記・表記の揺れなどを修正することでデータの品質を高めることを指します。

従来はExcelなどの表計算ソフトでデータを修正していましたが、Excelで扱うことのできるデータ量はせいぜい1万件程度であり、大規模データについては対応できません。

近年扱うデータが爆発的に増えたことにより、データの結合・変換などの加工処理を行うために適切なデータ処理基盤の設計・構築が必要になります。

何十・何百GBものデータを加工するためには、修正用のプログラムを開発し、処理に耐えられるサーバを用意する必要があります。

プログラムの開発費用、サーバ代、データ転送料、またデータ加工が定常的に発生する場合は、インフラ代に加えてデータ基盤をメンテナンスするコストがかかってきます。

データエンジニアを自社で調達するコスト

データエンジニアは、近年データの増大に伴い注目されてきた職種です。主に大規模なデータ活用を支えるデータ基盤の構築と運用を担います。

ストレージやデータウェアハウスなどのクラウドサービス、分散処理技術などを駆使して、利用者の目的やビジネス要件に応じたデータ基盤を構築し、データパイプラインを構築・運用します。

これまで専門職として切り出されていなかったため、プロダクトの開発者やインフラ担当者が本来業務の合間に従事していたケースがほとんどでした。

しかし、扱うデータの増大に伴って必要とされる知識やスキルセットが高度化してきていることもあり、専門家としてチームに加えなければ実用的なデータ基盤の構築は困難です。

とはいえ最近叫ばれた職種であり、採用しようにも市場にそれほど存在せず、スキルも体系化されていないため自社で教育することも難しいという課題があります。

インフラを理解しつつ、コードを書く技術も要求されるためシニアレベルのスキルが求められます。

glassdoorによると平均給与が約1,100万円(1ドル110円計算)となっています。

https://www.glassdoor.com/Salaries/data-engineer-salary-SRCH_KO0,13.htm

データサイエンティストや機械学習エンジニアに続く高単価なポジションとして認識されています。

私たちが本当にしなければいけないこと

SaaSやデータベースなど、複数のデータソースからデータを収集するプログラムの開発、そして大規模なデータを捌くデータ基盤の構築について理解はできました。

では、データ基盤を整え、データを整備することはできたとして、これで目的は達成されたのでしょうか?

いいえ、違います。

これから実際に分析や活用し、実際にビジネス価値を生まなければなりません。

データ整備にこれほどの工程を費やした後にやっと本格的なデータ活用に進めるのです。

データ活用の成否は、試行錯誤の回数、PDCAをどれだけ早く回せたかにかかっています。

すでに国外ではクラウド型のETL/データパイプラインツールの導入によりデータ基盤の構築・運用コストを大幅に下げた事例が増えています。

データ基盤の構築ならReckoner(レコナー)

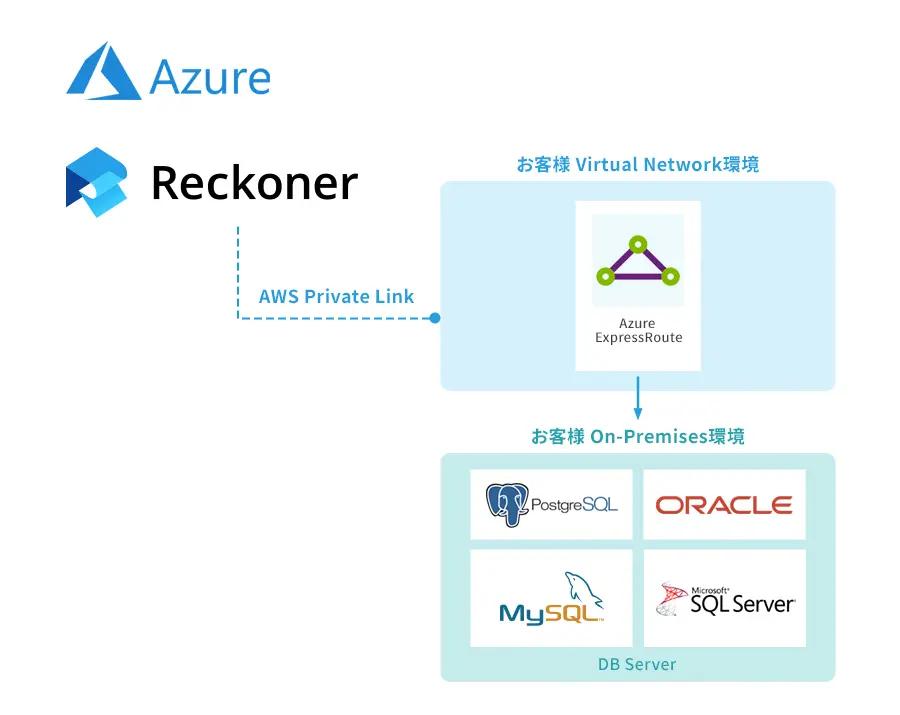

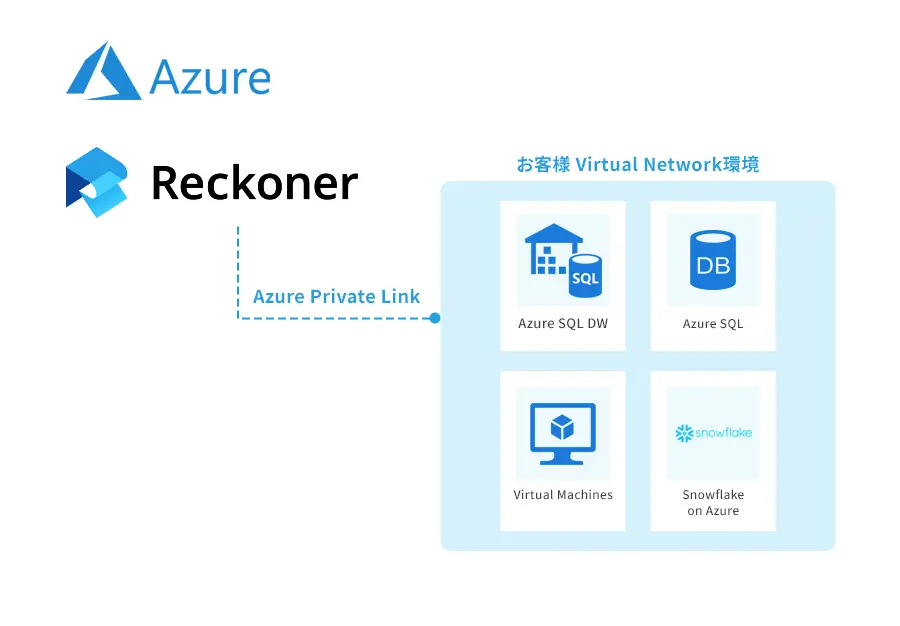

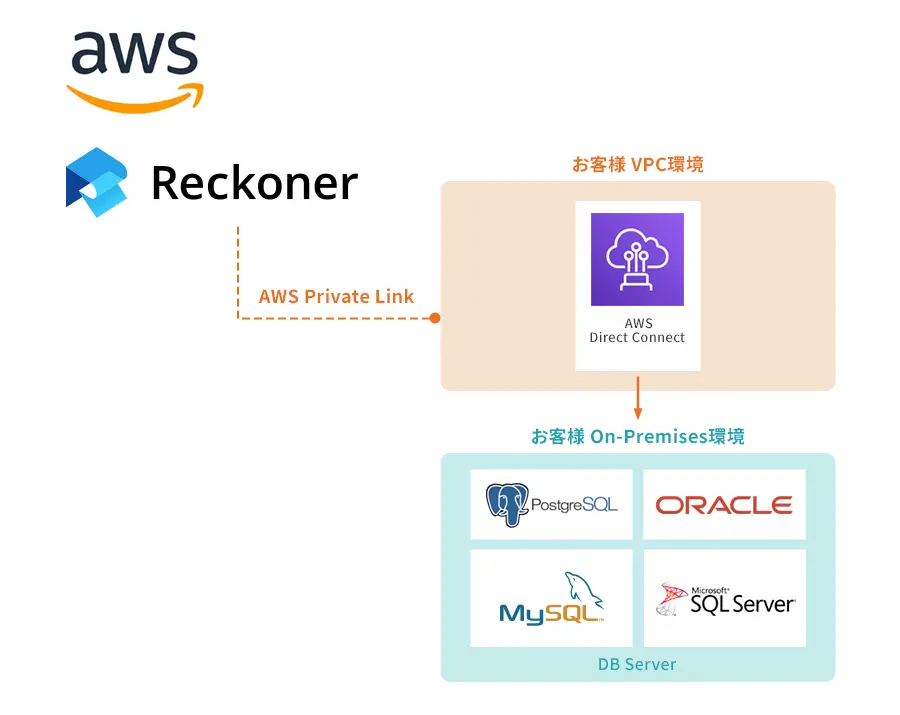

もし少ないリソースでデータ分析基盤を構築したいと考えているなら、Reckonerは最適なソリューションになるでしょう。

完全クラウドネイティブなため初期構築が不要、かつローコード/ノーコードで表現できる直感的なインターフェースなど、データ統合に必要な収集・加工・転送処理をシンプルかつ短時間に実現できるプラットフォームです。

もし、製品トライアルや自社の課題(ニーズ)にマッチするかどうかを知りたい場合は、お気軽にお問い合わせください。

ETLツールについて詳しく知りたい、ETLツールの選び方を知りたいという方はこちらの「ETLツールとは?選び方やメリットを解説」をぜひご覧ください。

関連記事

関連記事はありません。